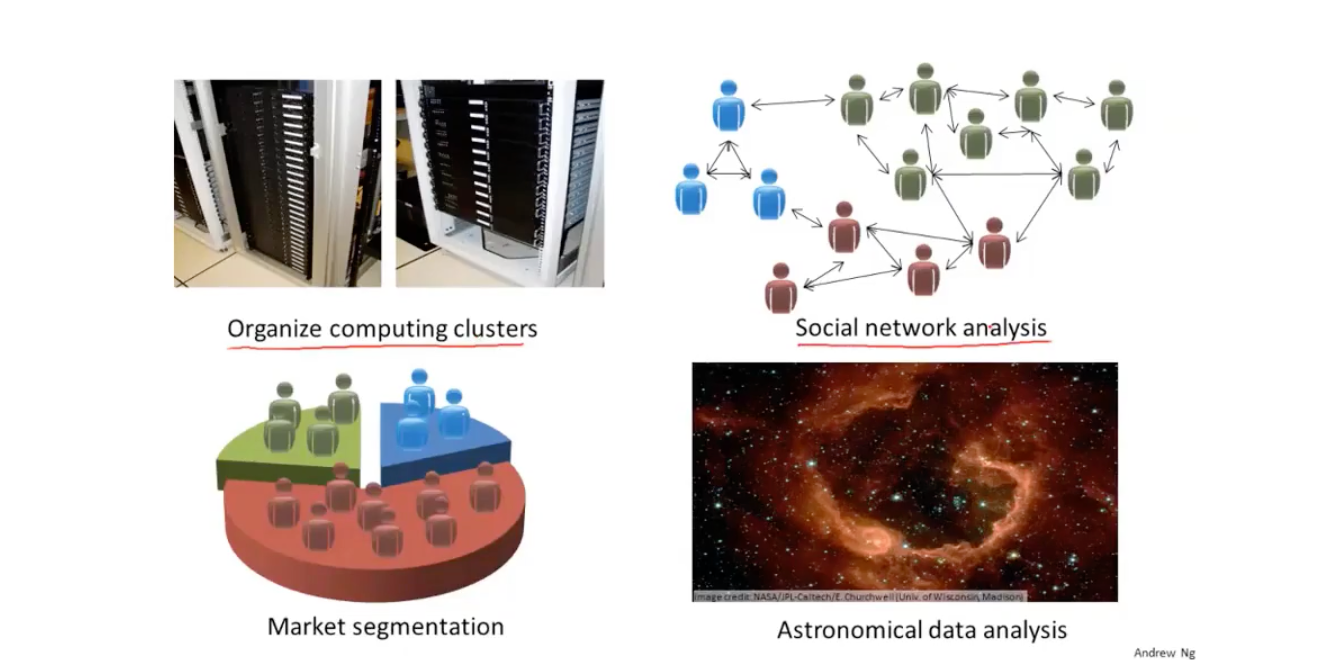

1-4.Unsupervised Learning

google news:聚类算法,无监督学习算法

聚类算法是unsupervised learning的一种

B is a unsupervised learning problem.

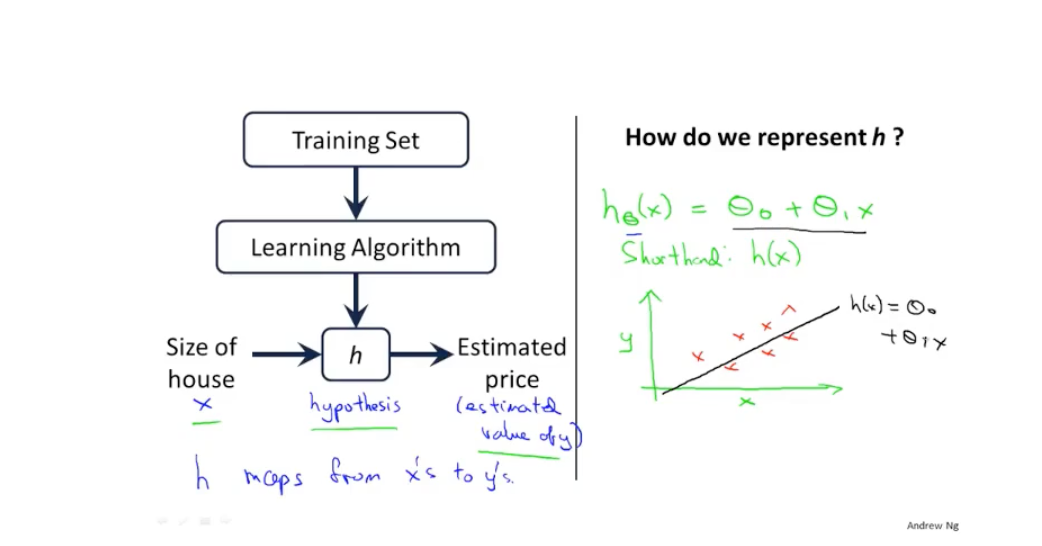

2-1.模型描述

根据拟合状况预估房价,是一个supervised learning problem,因为每一个大小都有一个“正确的答案”,并且还是回归问题。

Notation:

- m = Number of training examples

- x = “input” variable / features

y = “output” variable / “target” variable

(x,y) = one traing example

$(x^{(i)},y^{(i)})$ = $i^{th}$ training example (not exponentiation,i means “index”)

h = hypothesis

Linear regression with one variable.Univariate linear regression.(one variable)

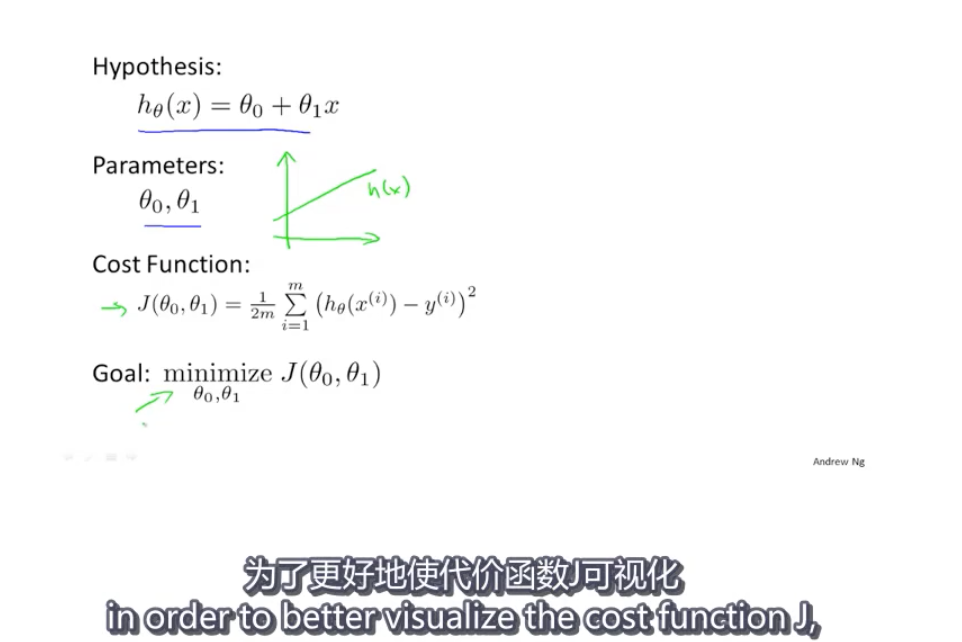

2.2代价函数(一)

Cost function

2.3代价函数(二)

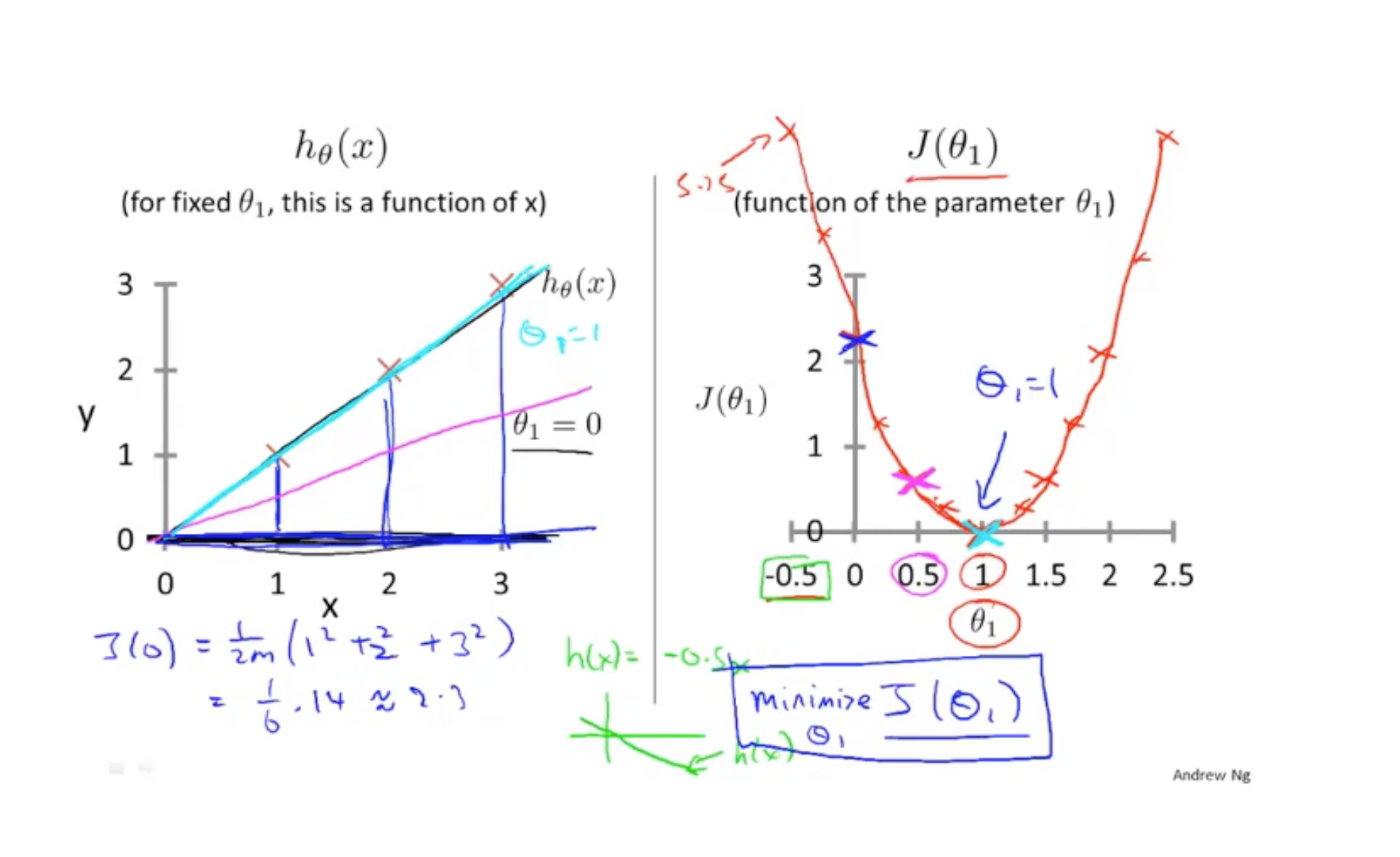

简化代价函数使得$\theta_0 = 0$,理解代价函数

对于上图特殊的training set,可以找出$\theta_1 = 1$时,可以完美拟合

2.4代价函数(三)

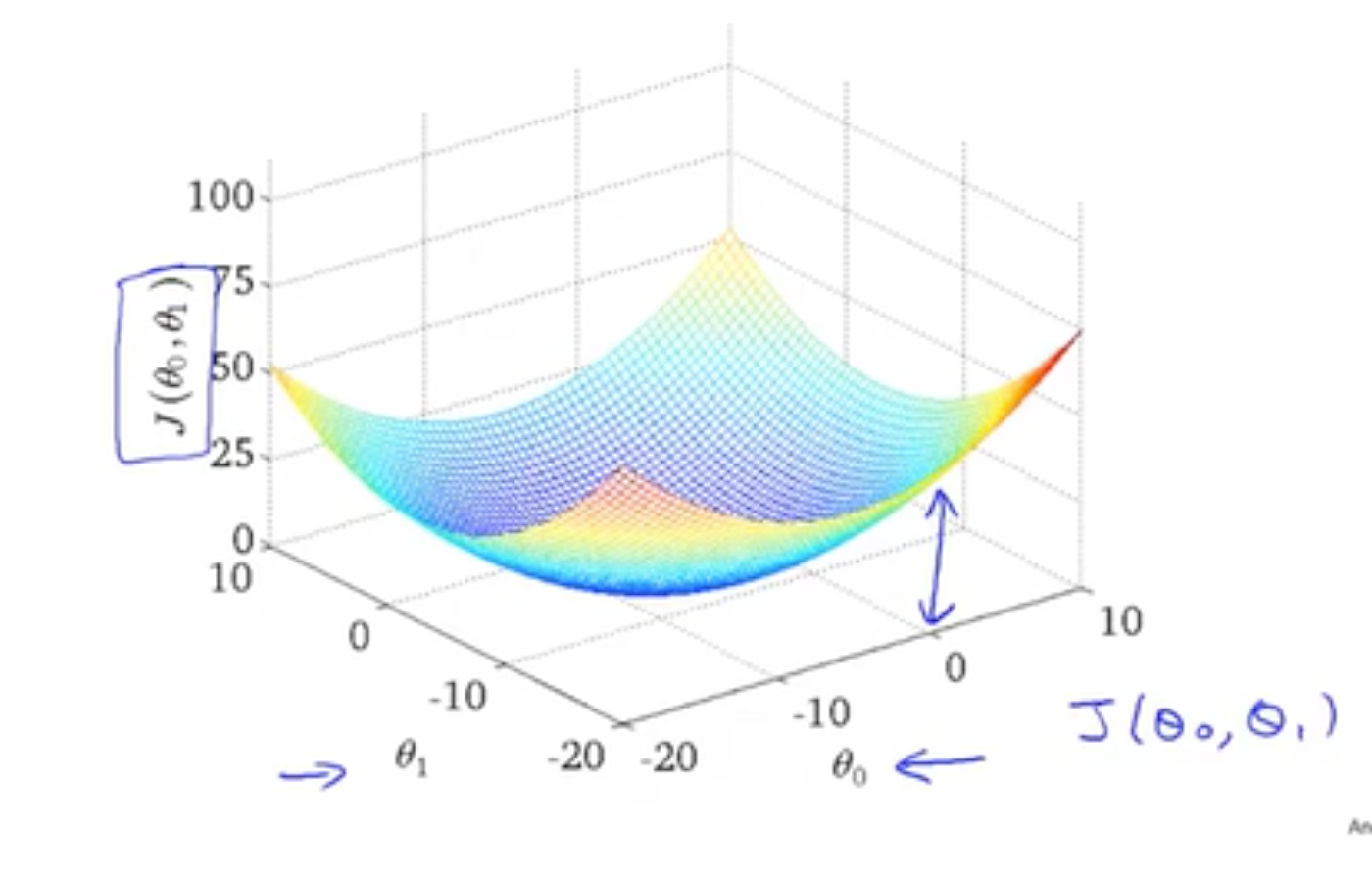

当我们使用$\theta_0$和$\theta_1$时,得到cost function图像类似下图

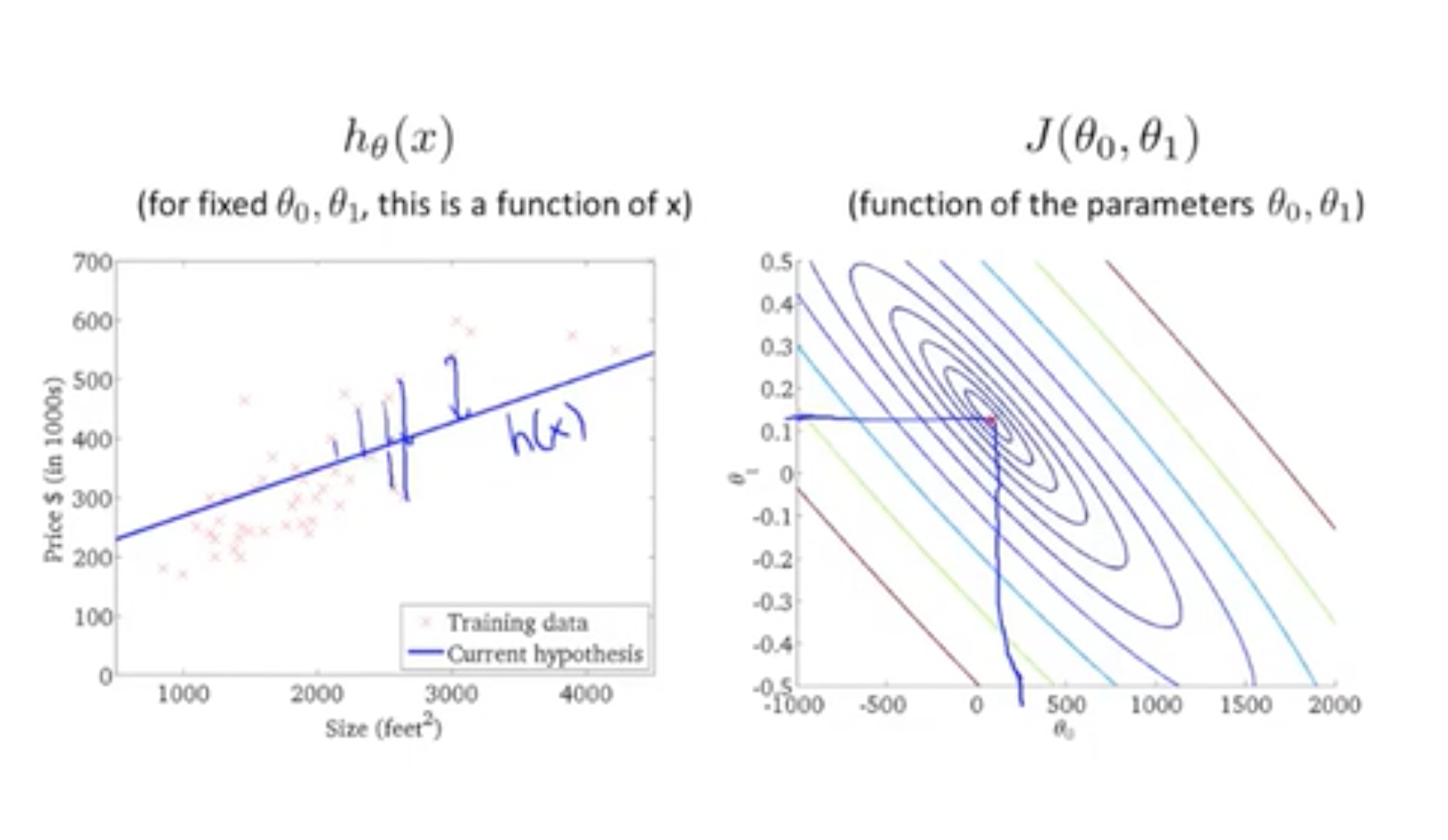

使用等高线的方式来模拟,想象从碗的上方向底部看,minimize J($\theta_0$,$\theta_1$) 就是椭圆的中心,如下图的数据拟合较为不错,cost value可以接受

2.5 梯度下降

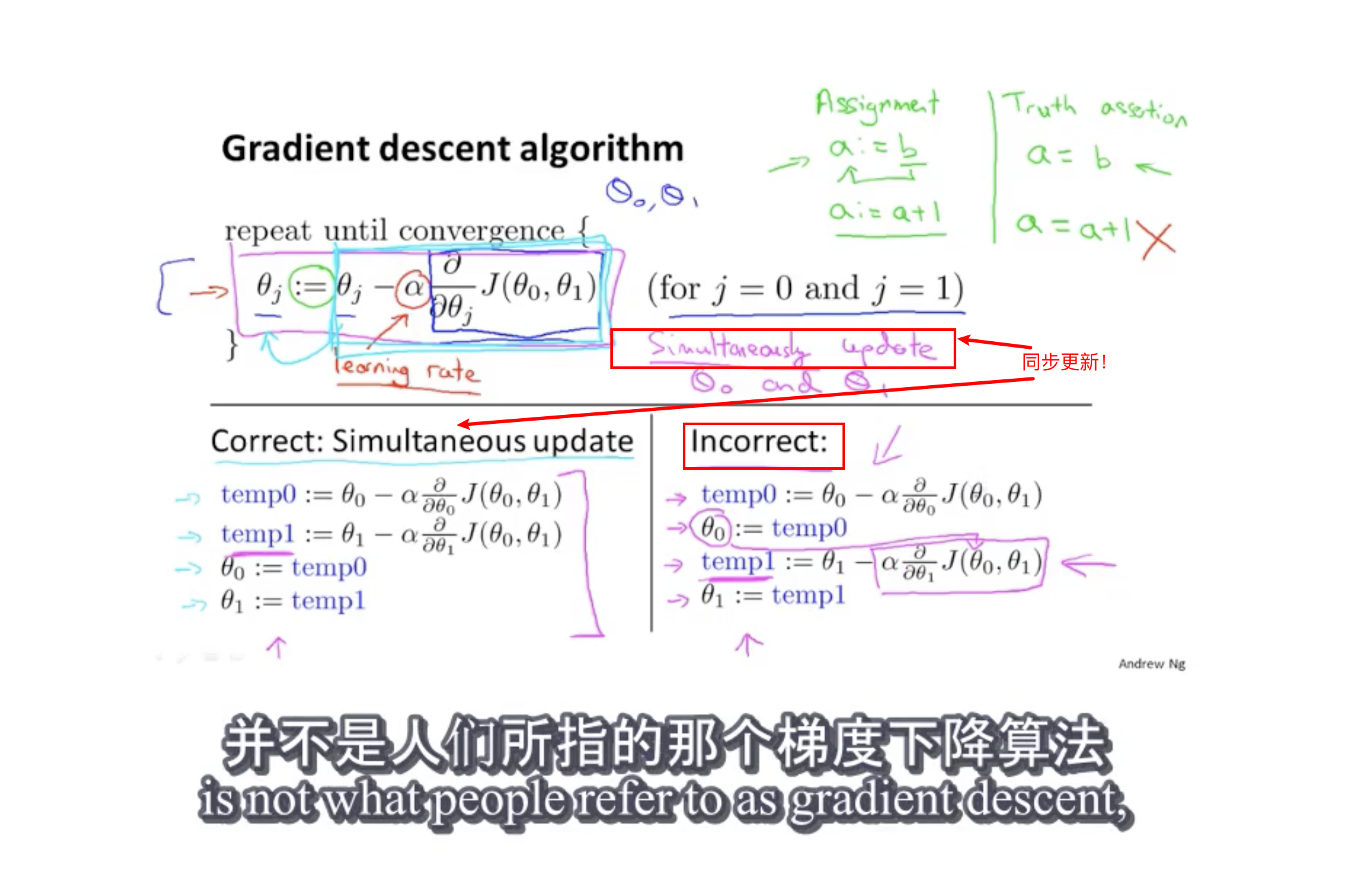

Repeat until convergence{

$\theta_j := \theta_j - \alpha\frac{\partial}{\partial\theta_j}J(\theta_0,\theta_1) $ (for j = 0 and j = 1)

}

// := assignment ( a := a + 1)

// $\alpha$为学习率,大的时候下山步子大

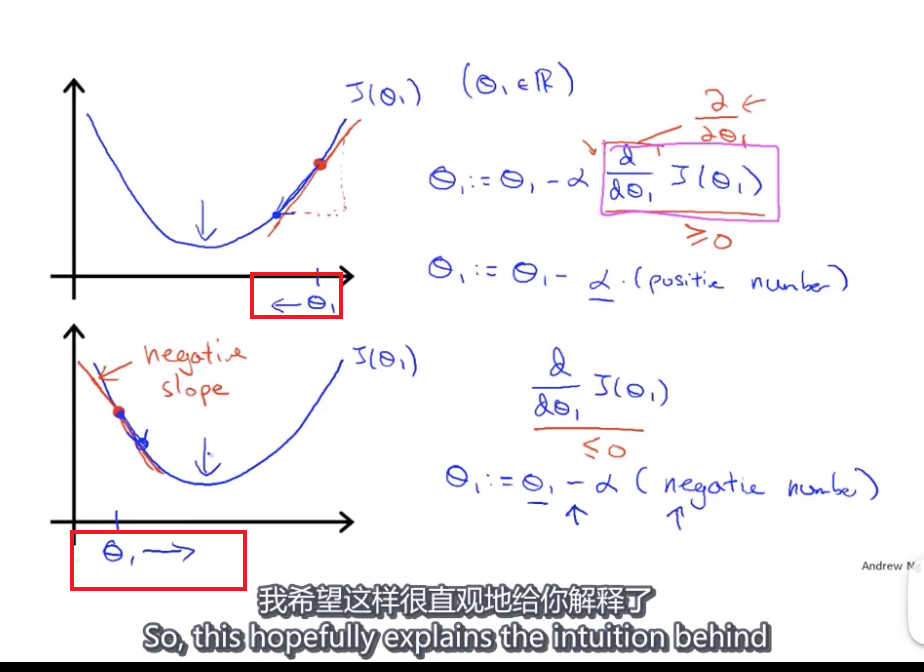

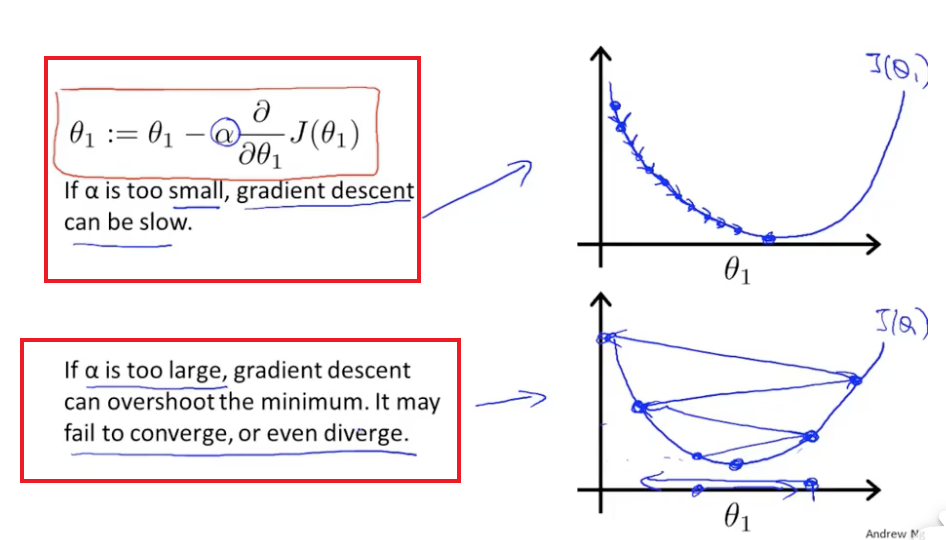

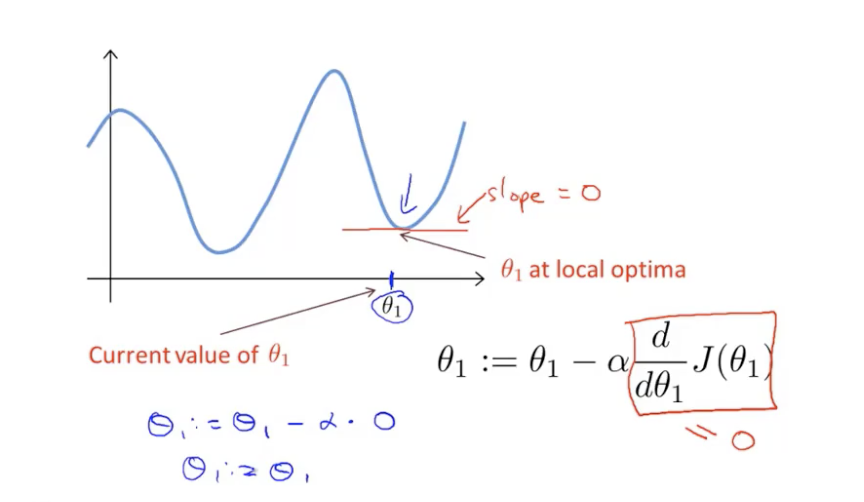

2.6 梯度下降理解

- 梯度下降导数项的意义

- 梯度下降学习率大小的意义

- 梯度下降到局部最优点的结果

2.7 线性回归的梯度下降

梯度下降中导数那一项:

$\theta_0$和$\theta_1$情况下的偏导数:

该方法是Batch梯度下降法:需要遍历整个训练集